Travis Scottの楽曲を機械学習したAIラッパー “TravisBott” のJack Park Canny Dope Man

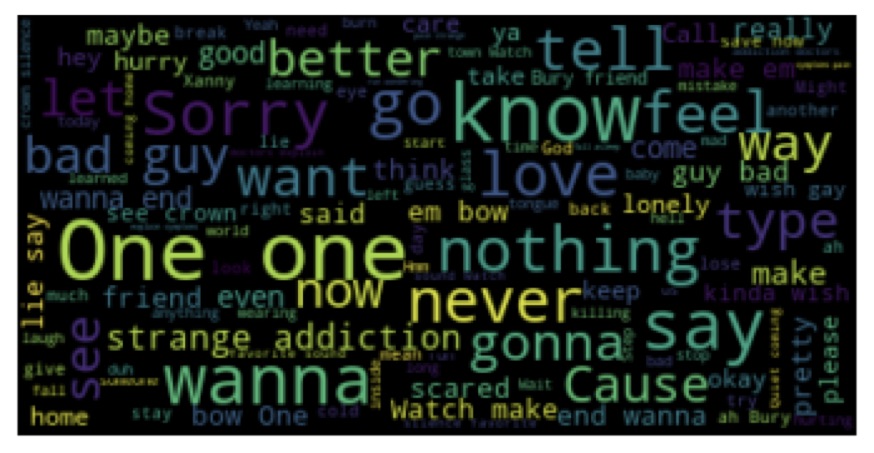

ウェブサイト制作やApp制作などを手掛けるアメリカのテック企業space 150 https://www.space150.com/ がTravis Scottの楽曲を機械学習させ生成した楽曲 ”Jack Park Canny Dope Man” をリリースしました。 デジタル処理が施されたMVのラッパーはTravisBottと名付けられています。 メロディー(なのでしょう、、、)だけでなくリリックも学習し生成されている様です。ただしトラックについては言及されていないのでそれはAIによる生成か、人の手によるものかは不明です。またアルゴリズムも不明です。(個人的にはアルゴリズムについて言及されていないものはあまり真には受けないのですが、、、、) リリックについては、以前投稿したこちらもご参照ください。(コードもあります) Rapを学習し自動リリック生成するAIのプログラムでKanye Westを学習させたらこんなリリックできましたhttps://canplay-music.com/2018/12/29/ai-lyrics/ Space150のディレクターであるNed Lampertはこのプロジェクトについて、Adweek(メディア)にリリック生成について面白いコメントをしていました。 「トラヴィスのAIは最初の頃、食べ物についてのリリックを生成し続けていた」例えば「I don’t want to fuck your party food」などだ との事です。 以前からお話している通り、ブレークビーツ、サンプリング、と他の楽曲をある種データとして”貪欲”に(とポジティブに表現しておきます)活用するのがヒップホップの歴史であり特徴です。近年のタイプビーツの例からも予想されますが、AI音楽のポップミュージック領域での活用例はヒップホップから始まる可能性も大いにあるのでは?と感じています。 ちなみにMVに出てくるコード。どんなアルゴリムか読み取ろうとしましたが、ただのsql(データベース)の操作。。。。。AIではありませんでした。。。。。 TravisBottの歌詞はこちらで確認していただけます。 https://genius.com/Travisbott-jack-park-canny-dope-man-lyrics

Travis Scottの楽曲を機械学習したAIラッパー “TravisBott” のJack Park Canny Dope Man Read Post »