音楽のディープフェイク?Open AIのJukebox解説

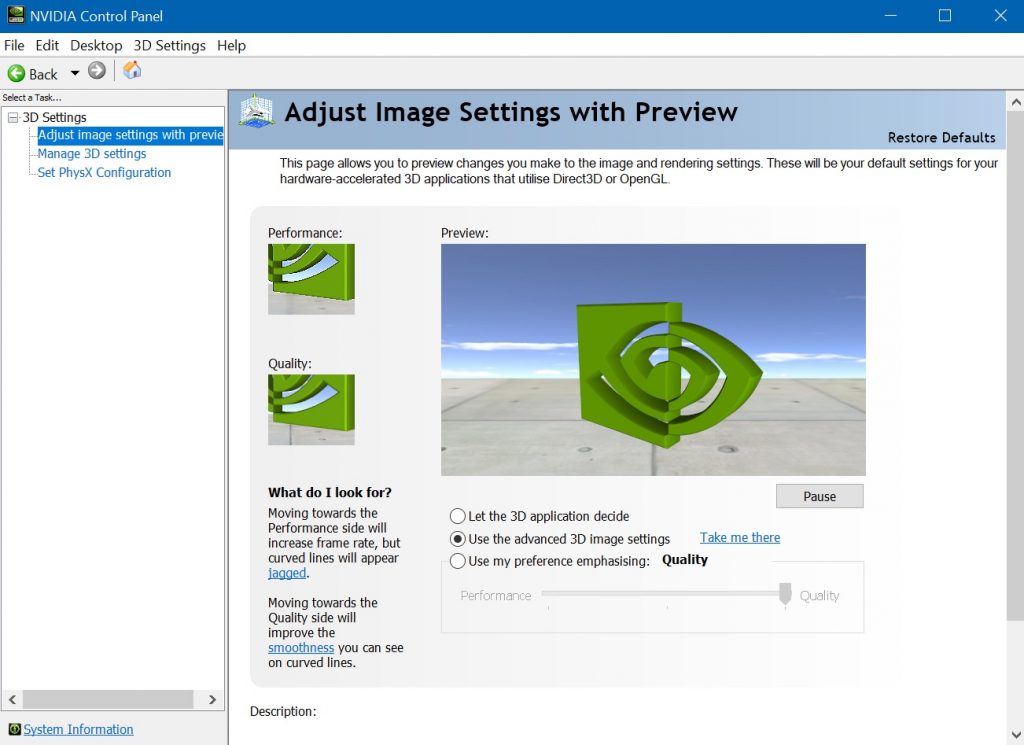

今最も進化した音楽生成AIと言っても良いでしょう。 あまりに高度な、そしてアーティストの音楽スタイルのみならず、歌声までもが生成できるため、音楽のディープフェイクと称されるOpen AIの音楽生成ニューラルネットワーク “Jukebox” https://openai.com/blog/jukebox/ 4月30日の発表から2ヶ月少々経過しましたが、昨日(7月11日)にCANPLAYでもようやく講義として取り扱う事ができました。その解説の中から一部を記事にして皆様にお伝えしたいと思います。 Jukebox概要 今回Jukeboxを発表したOpen AIは、イーロンマスクが設立時から支援を行っている事でも知られる非営利のAI(人工知能)研究機関です。 昨年2019年にMuseNetという、当時としてはもっとも高度な、音楽生成ニューラルネットワークを発表していました。(MuseNet解説の過去記事はこちら)https://canplay-music.com/2019/04/28/musenet/ そのMuseNetから約1年後の今回、新たな音楽生成ニューラルネットワークとして発表されたのがこのJukeboxです。当初、Jukeboxは、MuseNetの機能向上版なのではないか?、、、と予想していたのですが、その予想を遥かに上回る、全く次元の違う高度な音楽生成ニューラルネットワークへと進化していました。驚くべき進化です。 Jukeboxの特徴 Jukeboxの特徴です。 ・MIDIデータではなくオーディオデータを学習および生成・歌声まで生成・詩も生成・学習データは120万曲(うち約60万曲が英語の曲) 一番大きなインパクトはMIDIデータではなくオーディオデータそのものを学習&生成する事でしょう。(MIDIとは電子楽器の共通規格で、異なる電子楽器やコンピュータ間で音符データのやりとりを行う事ができます) 先にお話ししたMuseNetも含め、これまでの音楽生成AIはすべてMIDIデータ(音符)を学習し、生成を行っていました。 もし音楽のオーディオデータそのものを学習し、生成が行えるのであれば、色々な音響情報を含めた、遥かに高度な事が実現できます。しかしなぜ、これまでそれができなかったのか? オーディオデータはMIDIデータに比べあまりに取り

音楽のディープフェイク?Open AIのJukebox解説 Read Post »